안녕하세요 여러분, 물범쌤입니다 :)

최근 포스팅이 뜸했죠?죄송합니다.

그동안의 지식을 정리하고

미비한 교안들을 수정하느라 시간이 꾀 빠르게 흘러갔네요

그래도 여러분들께 알려드렸던 인스타그램 (@ai_moolbum) 에는

비교적 꾸준히 업로드 하고 있으니

AI 이미지 퀄리티가 궁금하신 분들은 참고해주세요 ^^

오늘은 많은 분들께서 활용하고 계시는

가장 핫한 프로그램인 flux를 사용해서,

추가 기능중에 가장 실용성이 높은 컨트롤넷을 사용해 보겠습니다.

바로 본론으로 들어가겠습니다 :)

※ 컨트롤넷 기본구조

본래 SD1.5v 의 컨트롤 넷을 기억하시는 분들께서는

컨트롤 넷 기능과 기능별 모델을 별도로 다운 받으셨던 기억때문에

머리가 아프실수도 있지만

SDXL버전의 컨트롤 넷 부터는 유니온이라고 해서 통합 버전이 나왔기 때문에

비교적 수월하게 컨트롤 넷을 구현하실 수 있습니다.

컨트롤넷의 기본 구조는 두 가지로 나뉩니다.

1. 컨트롤넷 구현을 위한 노드 설치

(GGUF,KJnode,Controlnet_aux)

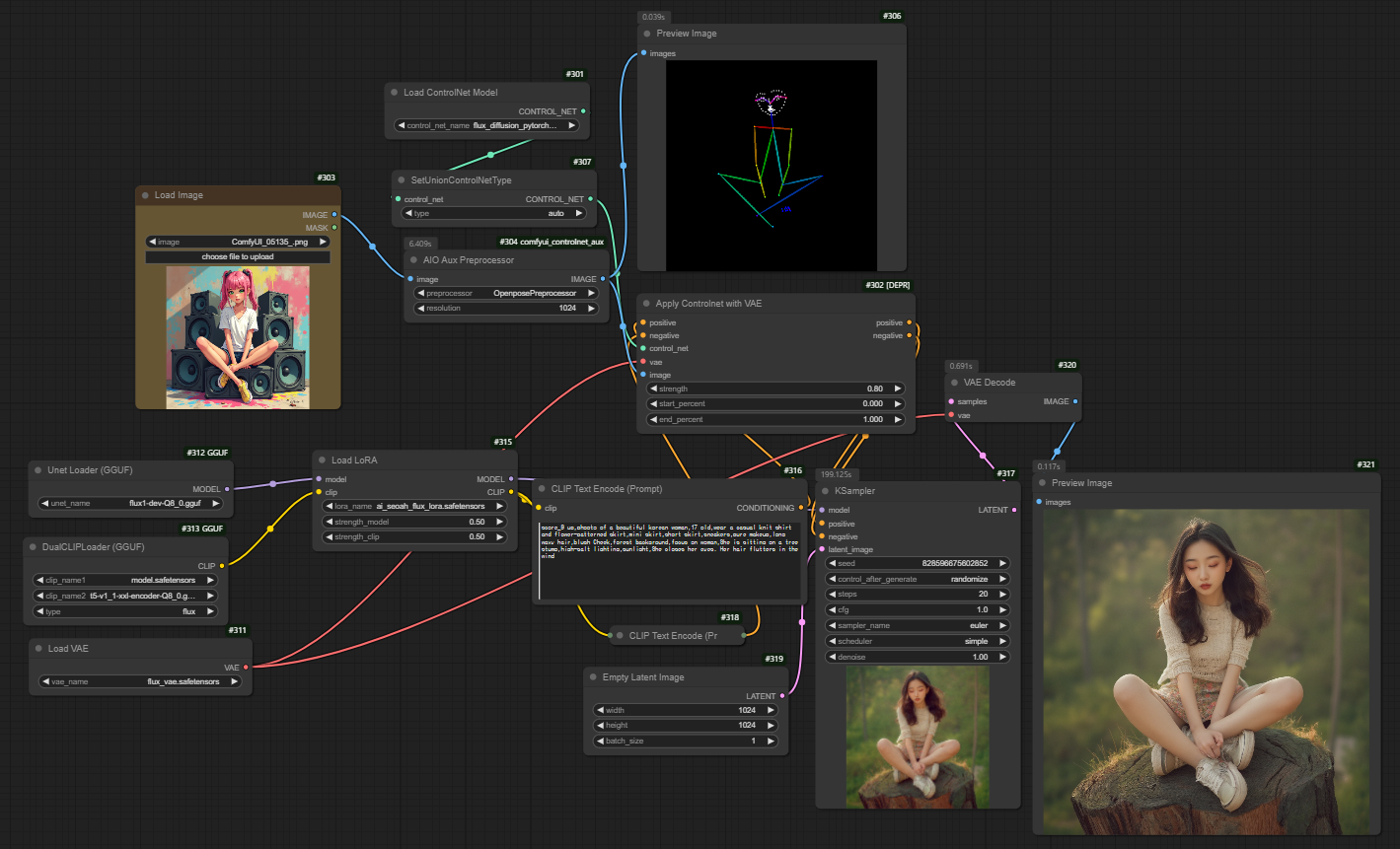

두 가지 단계가 완료되고 나면

아래와 같이 노드를 구성합니다.

복잡해 보이죠? 이미지를 동일한 사이즈로 생성한다는 전제 하에

필수 노드들만 남겨보겠습니다.

조금 간단해 졌죠?

컨트롤넷을 구현함에 있어서

필수적인 노드 3개

Load ControlNet model

SetUnionControlNetType

AIO Aux Preprocessor

그리고

컨트롤넷으로 추출된 이미지를

프롬프트 형태로 변환해서 이미지 생성부로 넘겨주는

Apply ControlNet with VAE

노드는 필수적으로 배치해 주셔야 합니다.

AIO Aux Preprocessor 노드에서 원하는 컨트롤넷 기능을 선택해 주세요

(depth,canny,openpose 등)

그 다음에는

Flux를 기본적으로 구성하는 노드 배치입니다.

저는 포스팅으로 안내드렸던 gguf 방식을 사용했지만

기본버전인 dev8 버전으로 사용하셔도 상관없습니다.

여기에서 중요한건 Ksampler가 프롬프트를 Clip노드에서 바로 받는것이 아니라

위에 배치한 Apply ControlNet with VAE 노드를 통해 입력받아야 한다는 점입니다.

그럼 노드 구성이 끝났으니 한 번 이미지를 생성해 볼까요?

포즈가 비교적 잘 적용되었죠?

하지만 생성된 이미지를 보면 손이라던가, 발이 여러개로 나오는 등

플럭스로 생성한 이미지라고 보기에는 품질이 많이 떨어집니다.

컨트롤 넷을 사용해서 바로 이미지를 생성하면

이렇게 품질이 저하되기 때문에

별도의 업스케일링을 진행해 주어야 하는데요,

하지만 우리가 평소에 사용하던 Ultimate SD Upcale 노드를 사용하면

업스케일 시간도 오래걸릴 뿐더러, 제대로 업스케일링이 되지 않습니다.

이 부분은 또 다음 포스팅으로 찾아뵙도록 하겠습니다^^

업스케일까지 진행하면, 아래와 같은 퀄리티로 이미지가 생성됩니다.

오늘은 Flux에 적용하는 컨트롤넷 기능을 알아보았습니다.

아무래도 현 시점에서 자연어 이해도와 퀄리티가 가장 좋은 모델이다보니,

flux를 기반으로 많은 기능들이 개발되는것 같습니다.

이 컨텐츠가 유익하셨다면

커피값은 기업들에게 받을테니

광고 한번씩만 눌러주시면 감사드리겠습니다 :)

그럼 모두 좋은 하루 되세요! ^^

'스테이블 디퓨전(StableDiffusion)' 카테고리의 다른 글

| PIKA의 새로운 기능을 체험해보세요!(AI영상) (13) | 2024.10.08 |

|---|---|

| Flux 업스케일 진행하기(ControlNet 관련) (0) | 2024.10.06 |

| Flux Lora를 제작하는 법 (무료) (17) | 2024.09.16 |

| AI 영상화에 도움이 되는 프롬프트 정리 (12) | 2024.09.08 |

| 이미 생성된 이미지의 표정을 바꿔봅시다(ALP) (4) | 2024.09.04 |